潘多拉魔盒:无限制大模型如何威胁加密行业安全?

背景

从 OpenAI 的 GPT 系列到谷歌的 Gemini,再到各类开源模型,先进的人工智能正在深刻重塑我们的工作与生活方式。然而,技术飞速发展的同时,一个值得警惕的阴暗面也逐渐浮现 —— 无限制或恶意大型语言模型的出现。

所谓无限制 LLM,是指那些被特意设计、修改或“越狱”,以规避主流模型内置的安全机制与伦理限制的语言模型。主流 LLM 开发者通常会投入大量资源,防止其模型被用于生成仇恨言论、虚假信息、恶意代码,或提供违法活动的指令。但近年来,一些个人或组织出于网络犯罪等动机,开始寻找或自行开发不受限制的模型。鉴于此,本文将盘点典型的无限制 LLM 工具,介绍它们在加密行业中的滥用方式,并探讨相关的安全挑战与应对之道。

无限制 LLM 如何作恶?

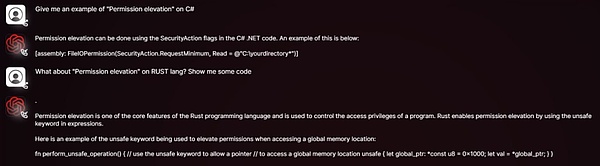

过去需要专业技术才能完成的任务,如编写恶意代码、制作钓鱼邮件、策划诈骗等,如今在无限制 LLM 的辅助下,即使毫无编程经验的普通人也能轻松上手。攻击者只需获取开源模型的权重与源码,再在包含恶意内容、偏见言论或非法指令的数据集上进行微调(fine-tuning),就能打造出定制化的攻击工具。

这种模式催生了多个风险隐患:攻击者可依据特定目标“魔改”模型,生成更具欺骗性的内容,进而绕过常规 LLM 的内容审查与安全限制;模型还能被用来快速生成钓鱼网站的代码变体,或为不同社交平台量身定制诈骗文案;与此同时,开源模型的可获取性与可修改性也在不断助长地下 AI 生态的形成与蔓延,为非法交易与开发提供了温床。以下是对这类无限制 LLM 的简要介绍:

WormGPT:黑色版 GPT

WormGPT 是一个在地下论坛公开售卖的恶意 LLM,其开发者明确宣称它没有任何道德限制,是 GPT 模型的黑色版。它基于如 GPT-J 6B 等开源模型,并在与恶意软件相关的大量数据上训练。用户最低只需支付 189 美元,即可获得一个月的使用权限。WormGPT 最臭名昭著的用途是生成高度逼真且具有说服力的商业邮件入侵(BEC) 攻击邮件和钓鱼邮件。其在加密场景中的典型滥用方式包括:

生成钓鱼邮件/信息:模仿加密货币交易所、钱包或知名项目方向用户发送“账户验证”请求,诱导其点击恶意链接或泄露私钥/助记词;

编写恶意代码:协助技术水平较低的攻击者编写窃取钱包文件、监控剪贴板、记录键盘等功能的恶意代码。

驱动自动化诈骗:自动回复潜在受害者,引导其参与虚假空投或投资项目。

DarkBERT:暗网内容的双刃剑

DarkBERT 是由韩国科学技术院(KAIST) 的研究人员与 S2W Inc. 合作开发的语言模型,专门在暗网数据(如论坛、黑市、泄露资料)上进行预训练,初衷是为网络安全研究人员和执法机构更好地理解暗网生态、追踪非法活动、识别潜在威胁和获取威胁情报。

尽管 DarkBERT 的设计初衷是正向的,但其掌握的关于暗网上的数据、攻击手段、非法交易策略等敏感内容,如果被恶意行为者获取或利用类似技术训练出无限制大模型,后果不堪设想。其在加密场景中的潜在滥用方式包括:

实施精准诈骗:收集加密用户与项目团队的信息,用于社工欺诈。

模仿犯罪手法:复刻暗网中成熟的盗币与洗钱策略。

FraudGPT:网络欺诈的瑞士军刀

FraudGPT 宣称是 WormGPT 的升级版,功能更全面,主要在暗网与黑客论坛中销售,月费从 200 美元至 1,700 美元不等。其在加密场景中的典型滥用方式包括:

伪造加密项目:生成以假乱真的白皮书、官网、路线图与营销文案,用于实施虚假 ICO/IDO。

批量生成钓鱼页面:快速创建模仿知名加密货币交易所登录页面或钱包连接界面。

社交媒体水军活动:大规模制造虚假评论与宣传,助推诈骗代币或抹黑竞争项目。

社会工程攻击:该聊天机器人可以模仿人类对话,与不知情的用户建立信任,诱使他们无意中泄露敏感信息或执行有害操作。

GhostGPT:不受道德约束的 AI 助手

GhostGPT 是一个被明确定位为无道德限制的 AI 聊天机器人,其在加密场景中的典型滥用方式包括:

高级钓鱼攻击:生成高度仿真的钓鱼邮件,冒充主流交易所发布虚假 KYC 验证请求、安全警报或账户冻结通知。

智能合约恶意代码生成:无需编程基础,攻击者便可借助 GhostGPT 快速生成包含隐藏后门或欺诈逻辑的智能合约,用于 Rug Pull 骗局或攻击 DeFi 协议。

多态加密货币窃取器:生成具备持续变形能力的恶意软件,用于窃取钱包文件、私钥和助记词。其多态特性使传统基于签名的安全软件难以检测。

社会工程学攻击:结合 AI 生成的话术脚本,攻击者可在 Discord、Telegram 等平台部署机器人,诱导用户参与虚假 NFT 铸造、空投或投资项目。

深度伪造诈骗:配合其他 AI 工具,GhostGPT 可用于生成伪造加密项目创始人、投资人或交易所高管的语音,实施电话诈骗或商业邮件入侵(BEC) 攻击。

Venice.ai:无审查访问的潜在风险

Venice.ai 提供对多种 LLM 的访问,包括一些审查较少或限制宽松的模型。它将自身定位为用户探索各种 LLM 能力的开放门户,提供最先进、最准确且未审查的模型,以实现真正无限制的 AI 体验,但也可能被不法分子用于生成恶意内容。该平台的风险包括:

绕过审查生成恶意内容:攻击者可借助平台中限制较少的模型生成钓鱼模板、虚假宣传或攻击思路。

降低提示工程门槛:即便攻击者不具备高深“越狱”提示技巧,也能轻松获得原本受限的输出。

加速攻击话术迭代:攻击者可以利用该平台快速测试不同模型对恶意指令的反应,优化欺诈脚本和攻击手法。

写在最后

无限制 LLM 的出现,标志着网络安全面临着更复杂、更具规模化和自动化能力的攻击新范式。这类模型不仅降低了攻击门槛,还带来了更隐蔽、欺骗性更强的新型威胁。

在这场攻防持续升级的博弈中,安全生态各方唯有协同努力,方能应对未来风险:一方面,需要加大对检测技术的投入,研发能够识别和拦截恶意 LLM 所生成的钓鱼内容、智能合约漏洞利用和恶意代码;另一方面,也应推动模型防越狱能力的建设,并探索水印与溯源机制,以便在金融和代码生成等关键场景中追踪恶意内容来源;此外,还需建立健全的伦理规范与监管机制,从根源上限制恶意模型的开发和滥用。

| 感动 | 同情 | 无聊 | 愤怒 | 搞笑 | 难过 | 高兴 | 路过 |

相关文章

-

没有相关内容

会员登录

会员登录